É inegável que a inteligência artificial, também conhecida como AI (artificial intelligence), se tornou onipresente em nosso cotidiano. Vez ou outra, vemos o termo passando por nossa timeline, não foi muito diferente com este artigo, não é? Mas se você decidiu entrar aqui e ler mais sobre o termo é porque finalmente entendeu que não tem como fugir: ela veio para ficar!

Todas as pesquisas e matérias, publicadas pelas mais variadas autoridades sobre o tema, afirmam que não só a AI se firmará como grande segmento da vida cotidiana até 2025, mas também a robótica como um todo.

Em 2015, um estudo realizado em 17 países mostrou que o uso de tecnologias, relacionadas à inteligência artificial, como aliadas dos mais diversos negócios adicionou uma média de 0,4% aos respectivos PIBs. O mais incrível é que esse pequeno grupo teve um aumento do Produto Interno Bruto, entre 1993 e 2007, que representou pouco mais de um décimo do crescimento global.

É por isso e muitos outros motivos que estamos falando de um negócio gigantesco, se ainda tem alguma dúvida disso, então não deixe de entender o porquê nesse artigo!

Mas, afinal, o que é a inteligência artificial?

“A inteligência artificial é um sistema informatizado que exibe um comportamento considerado comum por um indivíduo inteligente.”

Em outras palavras, a inteligência artificial (IA) é um sistema capaz de resolver racionalmente problemas complexos ou tomar as ações apropriadas para alcançar seus objetivos em qualquer circunstância do mundo real.

De certo modo, a inteligência artificial abrange a compreensão e recriação do comportamento da mente humana. Não se trata apenas de projetar computadores que imitam como pensamos, aprendemos e processamos informações, mas também como percebemos e sentimos o contexto geral que nos rodeia.

Para você entender esse complexo termo, não basta entender sua definição mais simplista. É preciso explorar um universo de terminologias que pertencem a esse universo e te mostram porque investir nessa área é fundamental.

O aprendizado de máquinas

Ou machine learning consiste em como os computadores que possuem a AI podem melhorar ao longo do tempo usando diferentes algoritmos (conjunto de regras ou processos), já que estes são alimentados com uma massa de dados.

As máquinas que possuem essa inteligência artificial aprendem reconhecendo tendências em dados que lhe permitem tomar decisões. Por exemplo, a projeção de veículos autônomos envolve a construção de aparelhos que aprendem a navegar.

Um sistema pode usar algoritmos e reconhecimento de padrões e a partir disso entender, dentre várias coisas, a identificar os pedestres e animais, de modo que possa frear ao ver desde um gato até mesmo uma zebra em seu caminho. É uma precisão incrível, não é mesmo?

Então basicamente, o aprendizado de máquinas se resume em como estas podem ser receptivas a uma grande massa de dados, identificar padrões e tomar decisões com base no seu aprendizado prévio. Pense nisso como um fluxo contínuo que se auto recicla.

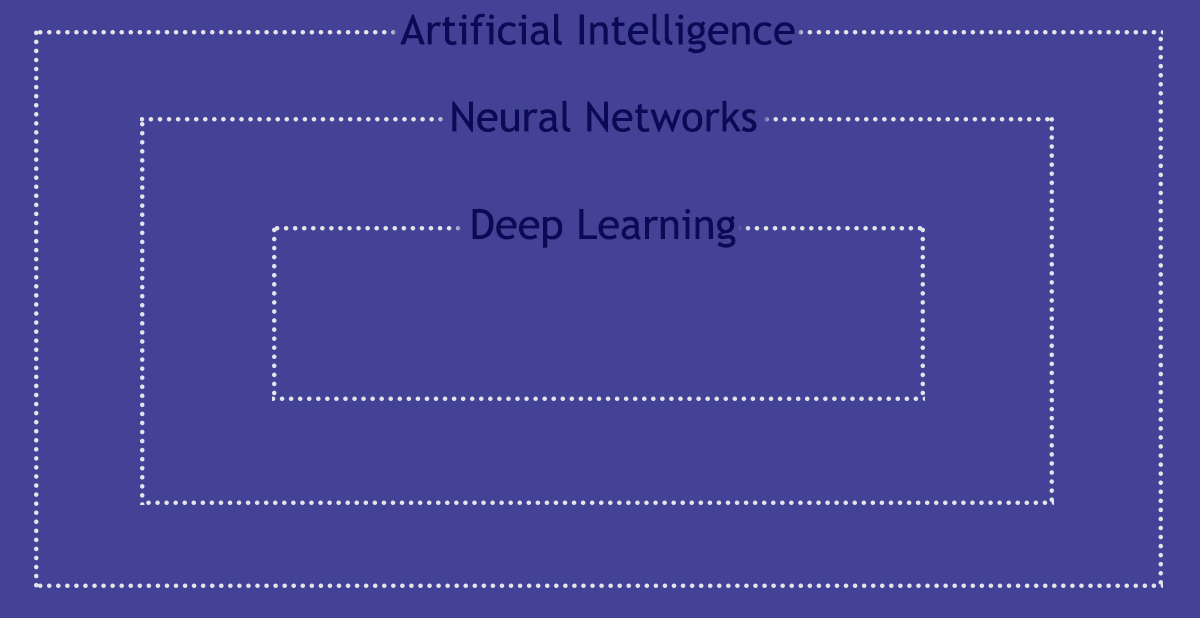

A rede de aprendizado neural

As redes neurais (neural networks) são um tipo de machine learning que se baseiam em como o cérebro funciona.

Existem diferentes tipos de redes neurais, mas, em geral, você pode entendê-las como um conjunto de nós (ou neurônios) interconectados que se organizam em múltiplas camadas. Para alimentar essa rede é preciso uma massividade de dados que enriqueça seu aprendizado.

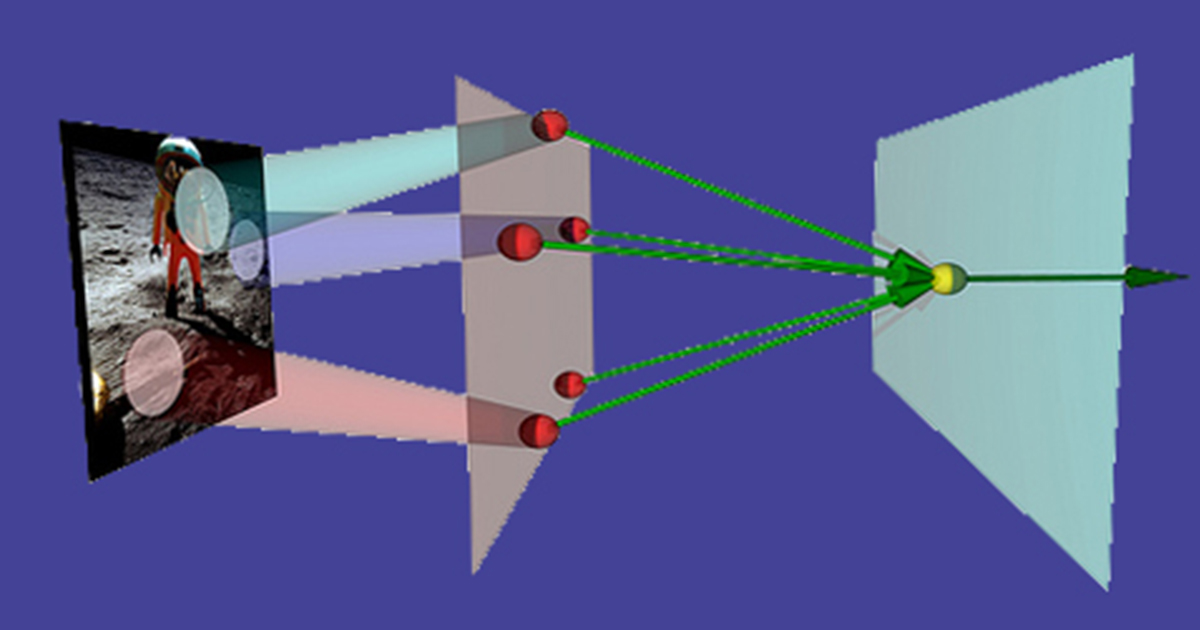

Para exemplificar, pense em uma tecnologia que sirva para o reconhecimento de imagens. Ela funcionaria da seguinte forma: uma primeira camada, com suas unidades, pode combinar os dados brutos presentes na imagem e, então, reconhecer padrões simples; um segundo nível combina os resultados da primeira camada para reconhecer padrões de padrões; a terceira camada pode combinar os resultados da segunda e assim sucessivamente, sempre fazendo análises mais profundas e específicas.

Maior precisão: deep learning

Você pode entender esse termo como uma rede neural ainda maior e mais complexa.

O deep learning é usado para reconhecer padrões extremamente complexos e precisos de dados. Algumas aplicações são o reconhecimento da fala (processamento da linguagem natural) e a visão computacional.

Para serem capazes de realizar tais tarefas, normalmente, as redes de aprendizagem profunda (tradução do termo) possuem muitas camadas, por vezes mais do que 100, com um grande número de unidades em cada.

Computer vision: as máquinas também enxergam

Quando você ouve esse termo pode ser que se lembre dos óculos 3D, mas a visão computacional vai muito além. Esse campo de pesquisa cria máquinas capazes de processar, entender e usar dados visuais, assim como os humanos.

Nesse caso, os olhos, geralmente, consistem em uma câmera. Algumas tecnologias que usam essa inteligência artificial são: os veículos autônomos e o dispositivo chamado kinect para Xbox.

Esse segundo usa um sistema sofisticado para capturar o movimento, assim o usuário pode interagir com o computador, em tempo real, sem o uso de um controle.

Natural language processing

O processamento de linguagem natural, ou natural language processing, permite a comunicação entre pessoas e computadores com uma tradução automática. Essa automatização permite que quando fazemos uso de tal AI interajamos facilmente com outras pessoas ao redor do mundo.

A Siri, tecnologia desenvolvida pela Apple, é um bom exemplo do processamento de linguagem natural. Ela auxilia no resultado final da experiência do usuário como um poderoso assistente: usando termos normais do cotidiano, a Siri te responde com áudios, apresentando dados ou fazendo um beatbox para você!

A inteligência artificial se importa com o que você sente

Não basta que computadores tenham acesso apenas a nossa inteligência racional para nos dar uma melhor experiência e sucesso nos projetos e investimentos. É preciso também que nossa inteligência emocional seja estudada e levada para as plataformas eletrônicas.

Justamente pensando nisso que se criou a computação efetiva (affective computing). Ela é responsável, não só por entender a emoção humana, mas também por influenciar emocionalmenteo usuário.

CPU ou GPU?

Muitas redes neurais funcionam a partir das Unidades de Processamento Gráfico, GPUs.

Elas, basicamente, ajudam os computadores a trabalhar muito mais rápido do que aqueles que operam com uma Unidade Central de Processamento (CPU). Algumas empresas criaram suas próprias versões de GPUs, uma delas: a Google.

Essa gigante da tecnologia possui um chip chamado Tenso Processing Unit (TPU) para suportar o mecanismo do software TensorFlow. A TPU impulsiona seus serviços de aprendizado profundo.

Cognitive computing (Computação cognitiva)

A computação cognitiva envolve sistemas de autoaprendizagem que utilizam a mineração de dados (daqueles importados), reconhecimento de padrões (machine learning) e o processamento de linguagem natural para imitar a maneira como o cérebro humano funciona. Um exemplo? O Watson, criação da IBM.

Essa tecnologia lida com informações simbólicas e conceituais ao invés de apenas dados, o que a torna capaz de tomar decisões de alto nível em situações complexas.

Se você se perdeu entre o conceito da inteligência artificial e da computação cognitiva, fique tranquilo, realmente não é tão fácil identificar as distinções. Alguns doutores no assunto entendem que a diferença entre esses dois termos se resume a ideia de que a inteligência artificial diz ao usuário o curso de ação a ser tomada com base em uma análise. Já a computação cognitiva fornece as informações para ajudar o próprio usuário a decidir.

Em outras palavras a computação cognitiva se torna apenas um encaixotamento eficiente para auxiliar a inteligência artificial como um todo.

Se você quer continuar conhecendo mais sobre esse assunto, assine nossa lista de e-mail específica abaixo!